Si vous suivez un peu l’actualité de la Gestion de l’Information, vous n’avez pas pu passer à côté du phénomène Big Data. Et comme pour beaucoup il n’est encore pas évident de bien comprendre ce que désigne ce terme anglo-saxon que l’on a bien du mal à traduire (grosses données, c’est pas terrible …), je passe beaucoup de temps à me documenter et à échanger avec les experts autour de moi pour arriver à construire une présentation la plus pertinente possible.

L’ordinateur Watson utilise des solutions analytiques et des composants de type Big Data

Je profite de ce travail personnel pour commencer une première approche écrite, et je vous livre ici ma compréhension de ce qu’est Big Data. Ce n’est ni exhaustif ni intangible, mais il faut bien commencer par quelque chose. Je vous invite au passage, si le sujet vous intéresse, à venir me retrouver le mardi 14 février dans le cadre de la conférence 01 Big Data. Ce sera l’occasion d’écouter les experts, de comprendre les problématiques, d’aborder les cas d’usages et d’avoir des échanges enrichissants.

Big Data, les 3 V

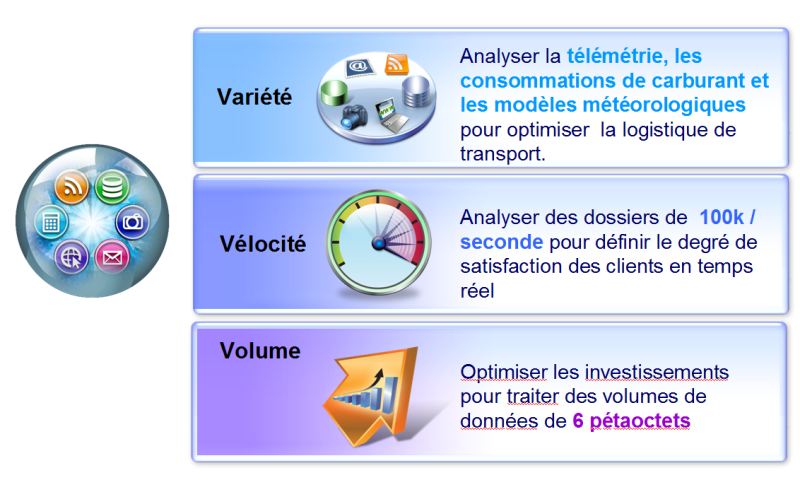

Pour définir ce qu’est Big Data, au-delà des aspects logiciels, organisationnels et architecturaux, il suffit de s’intéresser aux 3V :

- volume,

- variété,

- vélocité.

De grosses quantités de données, peu importe la quantité absolue tant qu’il s’agit d’un volume important pour votre activité, constituent un volume à prendre en compte qui ne peut plus être traité par une approche traditionnelle (comme celle mise en œuvre avec les bases de données).

Des données dont les formats sont hétérogènes, de natures diverses et variées, structurées comme non structurées, sont des données variées.

Si les données que vous manipulez vous arrivent à grande vitesse, que vous devez gérer des flux au fil de l’eau, que vous devez pouvoir les prendre en compte et les traiter tout aussi rapidement, alors vous avez une problématique de vélocité.

Si vous êtes confronté à une problématique de gestion de données correspondant à ces trois critères, alors vous avez à gérer une problématique de type Big Data. Ce qui signifie accessoirement que Big Data n’adresse pas uniquement les quelques entreprises en France qui manipulent beaucoup de données, mais bien toutes celles qui ont une problématique 3V.

Big Data, c’est pas pour moi

J’ai pour habitude de dire que le terme Big dans Big Data est mal approprié car beaucoup pensent qu’il faut énormément de données pour être plongé dans une problématique Big Data. Je ne pense pas. La notion de volume est à rapporter à votre activité : si pour un besoin donné, le volume à prendre en compte est supérieur à la moyenne de ce que vous savez déjà gérer, et en passe de croitre encore, si vous ne savez pas gérer ces données avec les architectures traditionnelles, alors vous avez un volume de type Big Data.

Big Data, c’est juste un concept

J’ai pu lire plusieurs articles ces derniers mois dont les auteurs décrivaient Big Data comme un simple concept (de plus) poussé par les éditeurs pour mettre sur le marché des offres qui au final n’étaient qu’un habile réhabillage d’offres existantes.

Il semble que ces gens là finissent par revenir sur leurs positions, et je préfère m’attacher à ce que proposent les analystes (Forrester, Gartner) qui positionnent Big Data comme une des dix problématiques clés des entreprises pour l’année 2012 (c’est maintenant).

Pour lire ce que dit le Gartner, je vous renvoie vers cet article Gartner, the top 10 strategic technology trends for 2012. Pour Forrester, c’est Brian Hopkins qui présente sa vision Big Data Will Help Shape Your Market’s Next Big Winners.

Big Data, architecture ou logiciels ?

Les deux. Si la mise en œuvre de Big Data fait appel à une architecture spécifique, il existe des offres logicielles dédiées qui viennent offrir leurs services. Big Data s’appuie sur le filesystem Hadoop dont une définition nous est donnée par Wikipedia :

Hadoop est un framework Java libre destiné aux applications distribuées et à la gestion intensive des données. Il permet aux applications de travailler avec des milliers de nœuds et des pétaoctets de données. Hadoop a été inspiré par les publications MapReduce, GoogleFS et BigTable de Google.

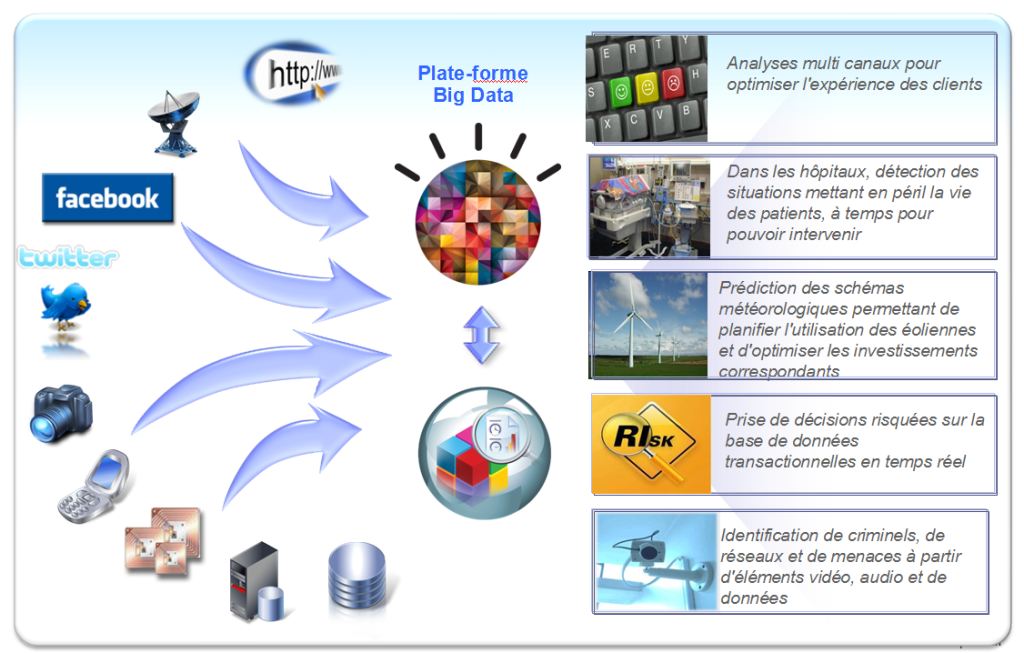

Pour ce qui est des logiciels, chaque éditeur a ses propres outils. Chez IBM c’est dans la gamme Infosphere que l’on trouve les deux offres Stream et Big Insight. Ces deux solutions sont spécifiquement conçues pour répondre aux problématiques d’analyse de flux de données, de qualification, traitement, référencement. Vous pouvez trouver un descriptif plus précis et des ressources documentaires ici Bringing Big Data to the Enterprise. Ces offres sont complétées des appliances analytiques de seconde génération Netezza.

Big Data, ce n’est que du stockage et de l’archivage

C’est ce que tendent à faire croire ceux qui ne disposent que d’une offre d’archivage (petite pique gentille à certains de mes confrères). Mais Big Data demande d’autres capacités, comme celle de savoir analyser les flux de données, les interpréter en temps réel, en extraire les données essentielles à destination des utilisateurs métiers, etc.

Pour aller plus loin …

Si le sujet Big Data vous intéresse, je vous invite à visiter les sites précédemment cités. Vous pouvez aussi parcourir l’ebook « Understanding Big Data » gratuit après enregistrement.

Sur Twitter, suivez le tag #bigdata (et abonnez-vous à mon compte, j’en parle régulièrement).

Et n’oubliez pas le 14 février pour la conférence 01 Big Data.

Vous avez des compléments, des exemples, des cas d’usages ? Laissez un commentaire.